ARTICLES

AIが自ら思考し、判断する(かのように振る舞う)ようになり、人間の行動を代替する社会では、AIに「権利」や「責任」は発生するのでしょうか? そこに従来の法は適用されるのでしょうか? 今回は、ロボットやAIに関する法律の専門家とともに、AIが社会基盤となる未来について、参加者の皆さんと考えました。

【ゲスト】

工藤郁子

マカイラ株式会社コンサルタント上席研究員、中京大学経済研究所特任研究員、一般社団法人日本ディープラーニング協会 有識者会員。

共訳に、ウゴ・パガロ著『ロボット法』勁草書房(2018)。また、共著に『ロボット・AIと法』有斐閣(2018)。

雇用と労働——AIは人間の雇用を奪う?

工藤:私は、ロボットとAIに関わる法という比較的新しく、いろいろな分野が混じり合った領域の研究をしています。このイベントでは、コメントや質問はいつでも歓迎します。

さて、ここで挙手をお願いします。まず、AIの台頭によって人間の職を奪われないか不安に思う人は? (会場の数人が挙手)……意外と少ないですね。一方、特に不安ではないという人は? (会場の半数以上が挙手)……皆さん結構自信がおありなんですね(笑)。

では不安と思った方へ、なぜそう思ったか教えてください。

会場:大学で経済学を専攻していて、まさに「AIが雇用にどう関わってくるか」を研究しています。雇用が奪われるかどうかより、賃金が下がるのではないかという不安の方が強くあります。

工藤:ありがとうございます。賃金などでじわじわ打撃があるかもしれない、というご意見ですね。では、不安はないという方のご意見は?

会場:不安より、どんな世の中になるのかという期待感のほうが強いです。

工藤:なるほど。普通こういった会では、不安を感じていたり、怖いと思ったりしている人の方が多いのですが、ここはちょっと特殊ですね。新しいイノベーションにワクワクして、どんな社会が訪れるんだろうと期待している方が多いんでしょうか。

「AIが雇用を奪う」と関心が高まるきっかけとなった論文(https://www.oxfordmartin.ox.ac.uk/publications/view/1314)があります。そこでは「アメリカの就労者のうち47%が、今後10〜20年でAIに代替される可能性が高い職業に従事している」と推測されていました。日本でも似たようなリサーチがあり「就労者の半分ぐらいは、職が奪われるのではないか」と報道されて、多くの人が不安に陥りました。

特に今まで機械に代替されないと考えられていた、ホワイトカラーと呼ばれる職種、頭脳労働、クリエイティブとされる仕事……具体的には絵画や音楽の制作、病気の診断といったことまでできるAIが登場して、誰にとっても他人事じゃないという感覚が高まっているのではないかと思います。

一方、この研究に関しては異論もあります。仕事というものは様々なタスクで構成されているはずなので、職業ごとに機械化の可能性を推計することには無理があるのではないか、という指摘です。絵を描くにしても、絵の具を混ぜ、構成を考え、筆で色を塗り……と、多くのタスクがあります。このようなタスクベースで推計し直すと、AIによって7割以上自動化される可能性のある職業は9%程度で、そんなに大きなインパクトはないのではないか、とする研究もあります。

アメリカのホワイトハウスの報告書『Artificial Intelligence, Automation, and the Economy (AI・自動化と経済)』によると、失業率に大きな変化はないかもしれませんが、労働市場において必要とされる技能が変化し、特に低賃金、低熟練、低教育の労働者がAIに代替されてしまうのではないかという懸念が表明されています。そして、AI研究開発の投資、雇用訓練への投資、あるいは失業保険や再就職支援といったセーフティネットの整備増強に取り組むべきである、という提言がなされています。

別の見方もあって、ドイツでは、むしろ高スキルと低スキルの雇用は増加する一方で、その中間層、つまりルーティーン的な業務の雇用が減少して二極化が生じ、格差が広がるのではないかという強い懸念が示されています。

私も報告書(※)で「生産活動の自動化が進む結果、労働力需要が変化し、雇用・労働分野に負の影響が及ぶのではないかとの懸念・不安が存在する」と書きました。今は、本当に労働力需要が変化するか、変化するとすればどのような形で、どういったセーフティネットを構築すべきか、どのように労働の法制を変えるべきか、ということを法律家の方々と議論している段階です。

※米国における AI・ ロボットと雇用政策動向」国立 国会図書館『人工知能・ロボットと労働・雇用をめぐる視点: 科学技術に関する調査プロジェクト報告書』(2018)88頁

ロボットやAIに、税を課すべきか?

工藤:2017年、欧州議会の法務委員会で議論された「ロボット税」について説明します。今後、ロボットやAIの普及によって人間の雇用が減少し、社会保険料や税収が減ってしまったときの対策として、まず、AIなどを搭載したロボットを所有する企業に対してロボットの登録を義務付け、ロボットの活用で得られた利益の一部を負担させる「ロボット税」を導入しようという提案です。そしてその税収をもとにベーシックインカムを導入したり、機械により失業してしまった人が次の職につけるような教育訓練の充実を図ろう、というものです。

しかし、これに対してさまざまな組織・企業が反対を表明しました。特に国際ロボット連盟やドイツ機械装置産業連盟などから「労働者の1万人あたりのロボット台数(いわゆる「ロボット密度』)と、雇用者数の間には正の相関関係がある。つまり、ロボットを導入したからといって雇用が奪われているわけではない」という問題提起がありました。

欧州議会側も、ロボット税の導入がロボットの普及を阻害して、アメリカや中国に対するEUの競争力低下につながり、ひいては人間の雇用喪失に繋がるという見解を表明しました。結局、ロボット税というアイデアは提案されましたが、導入には至りませんでした。

さて皆さん、ここまでの議論を踏まえて、AIやロボットに課税すべきだと思いますか? そう思う理由を教えてください。

会場:こういった技術や制度には、格差の是正メカニズムみたいなものが付随している必要があると思います。

工藤:なるほど、先ほどお話したドイツの議論で懸念されていたように、中間層の雇用が奪われて高スキル人材と低スキル人材に二極化すると、社会に格差が生じて問題ではないか、それを是正するためには新しい制度を導入したほうがいいのではないかということですね。ありがとうございます。

では、課税すべきでないという方は?

井上(当財団代表理事): 僕は大前提として、AIは「GAFA(※)」のような企業が牽引して民主化が起こり、コモディティ化が進むと思っています。そうするとAIもパソコンと変わらない。つまりパソコンが効率的だからといって、それを使って仕事している人に課税しませんよね。それと同じ議論だと思います。セーフティネットを作るなら、AIやロボティクスへの課税に求めるのではなく、別の社会的なイデオロギーのもとに考えるほうが健全だと思います。

※GAFA=IT市場を牽引する大企業で、Google・Apple・Facebook・Amazonのこと

工藤:GAFAについて補足します。彼らはSNSやEコマースの大企業ですが、AIの開発に巨額の投資をしていて、ビッグデータ・ビジネスやアルゴリズム等を彼らが主導していくと言われています。なので、中国や欧州はアメリカの一極集中になってしまうのではないかと強い警戒感を持っています。ですが今のご意見では、AIは民主化が進んでオープンになり、誰もがAIを開発したり、使える環境が整う。そうするとパソコンと同じで、AIやロボットを特別に捉えて制度を構築するよりは、一般的な話としてセーフティネットや税制を考え直すほうがよい、というご意見だったと思います。

両方の立場について伺いましたが、どちらもあり得ると思います。日本ならどっちがフィットしそうか、アメリカだったらどういう戦略をとるか、アメリカや中国に対抗するために日本はどういう戦略や法制度がありうるか、あるいは国際的なハーモナイズを考えると、どの辺りがバランスなのか……など、モヤモヤと考え続けていただきたいです。

AIが労働の定義を変える?

工藤:これ以外にも論点はあります。例えば、近世の貴族階級や古代ローマでは、今とは全く違う労働観を持っていたはずです。例えばモンテスキューは「商人には商人の働き方があるように、貴族には貴族の働き方がある」と言っています。この場合、商人はなんらかの労働力を売り買いしている人。一方、貴族の働き方は商人とは違って、重んじられるのは名誉や尊敬。こうしたお金に換え難いものを交換して働いていたのかなと思います。

もし、AIやロボットの導入によって多くの仕事が代替されて、遊んで暮らせる余裕が生まれたら、労働の意味や価値を定義し直したり、自分で見つめ直したりする必要があるかもしれません。そうはいっても、現代社会では身分制はないことになっているので、モンテスキューの時代と同じ労働観は通用しません。貴族の名誉や尊敬と同じものが、現代において尊重され重んじられるのか? そうならないかもしれないし、通用させるべきではないのかもしれません。モヤモヤと、今後の自分の働き方を考えていただければと思います。

会場から、質問どうぞ。

会場:ロボット税についてですが、AIに課税しているとも、固定資産に課税しているとも見えます。どっちの視点で見ればいいのでしょうか。

工藤:おっしゃる通り、固定資産税や法人税率などを上げるほうが、現状ある制度を利用するので、衝突や摩擦は少ないのではないか、という意見もあります。ロボット税に関して提示された問題意識をもとに、法人税が上がる可能性は十分にあると思います。

会場:AIに課税するとき、AIは「一人」「二人」と数えるのでしょうか?

工藤:いい質問、ありがとうございます。確かに、AIはネットワーク化されてインターネットやクラウド上にあるので数えられないのではないか、という意見は少なくありません。カウントできないものであれば、そもそも課税なんて無意味じゃないか、と。それに、AIやソフトウェアの数え方を法律で決めたとしても「この100個のAIは全部一つです」などと脱法行為をする人が多くなるだろうから無意味じゃないか、という意見もあります。ロボット税が否定された背景にはそういう実務的な理由も大きいと思います。

行為と責任——AIによる行為の責任は誰にあるか

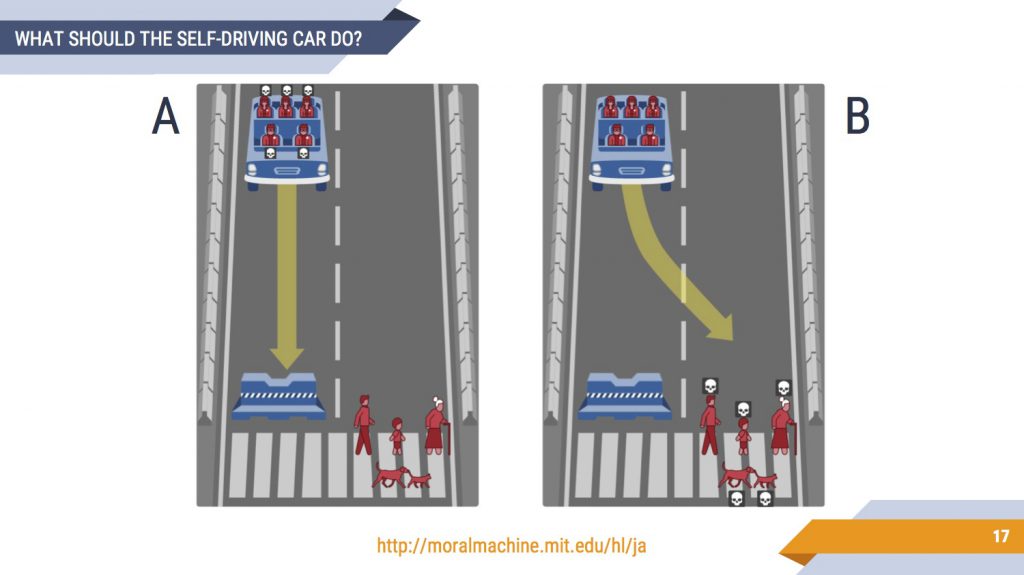

工藤:モラル・マシンというサイトにアクセスしてみてください。いま映写しているような二択の問題が次々と提示されます。この問題では、Aの場合は自動走行車は障害物に当たり、車に乗っている5人が死にます。Bだと、乗車している5人は被害を免れますが、歩行者3人と犬猫二匹が死にます。あなたなら、AとBどちらを選びますか?

これは「ある人を助けるために、ほかの人を犠牲にすることは許されるか」という倫理的なジレンマを問う、いわゆるトロッコ問題です。これらの問題に対する回答から人々の倫理観のバランシングがどこにあるのかを調査して、自動走行におけるAIの道徳的な意思決定に反映しようとしています。

現行の刑法では「緊急避難」という考え方をします。刑法37条1項前段で「自己又は他人の生命、身体、自由又は財産に対する現在の危難を避けるため、やむを得ずにした行為は、これによって生じた害が避けようとした害の程度を超えなかった場合に限り、罰しない」とされています。つまり、事故が起きそうで、自分が死んでしまうかもしれないときやむを得ずした行為は、これによって生じた害が、避けようとした害の程度を超えなかった場合に限り罰しない。先ほどの事例でいうと、もし3人死ぬより5人死ぬ方がましだと考えられるケースであれば罰せられない、という構成を日本の刑法学ではとっています。もちろん、被害状況を死者の数で天秤にかけていいのかという問題はあります。この問題意識は、あとで紹介しましょう。

さて、自動走行車では、場合分けが必要です。自動運転のいわゆるレベル3以下では、一定の事情によって自動運転システムのモニタリングに限界が生じると、システムから人間のドライバーに運転操作を交代する「オーバーライド」が起きて、人間の判断に委ねられることになります。そうすると自動走行車とはいえ人が運転している場合とほとんど変わらなくなるので、現行法上では従来と変わらず、運転者の「故意」や「過失」が問題になると言われています。ただ自動走行だと、オーバーライドが起きる前には、みんなスマホをいじったり音楽を聞いたりと自由に過ごしているでしょうから、従来の車の運転と同様の前方注視義務を課していいかどうか議論があり、いま警察庁がガイドラインを作ろうとしているところです。

ではレベル4以上、つまり定義上は人間の運転によるオーバーライドの必要性が想定されていない自動走行車について考えてみましょう。運転している人には責任を負わせることができません。では誰に責任を求めるか。自動走行車のシステムを設計・製造した人に過失責任があるのか? つまり、設計者の刑事製造物責任、特に緊急避難の成否が問題になってきます。

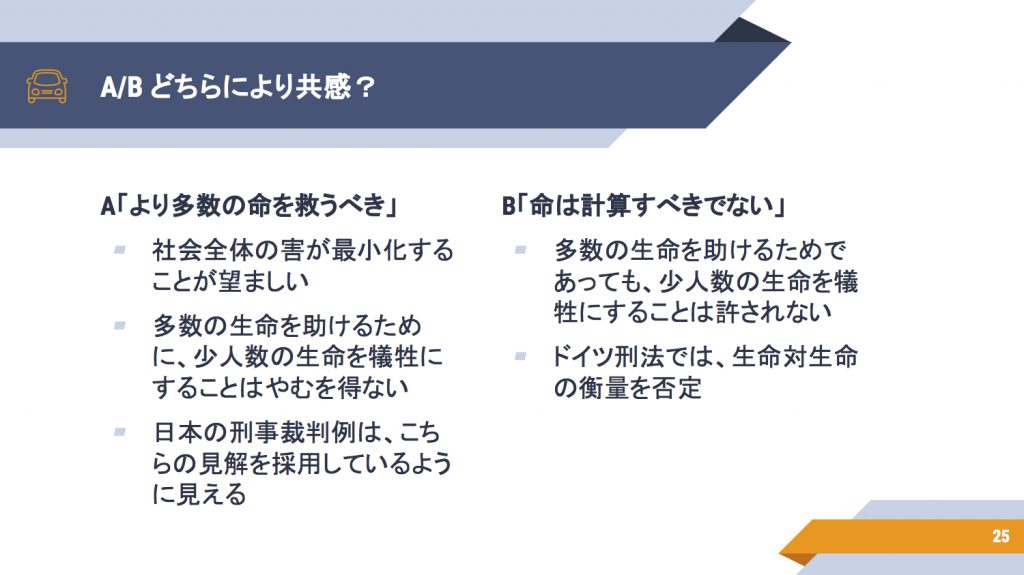

以上を踏まえて質問です。皆さんはAとB、どちらの考え方に共感しますか?

ドイツの刑法の根本には「命は計算すべきではない」という考え方があります。かつて、「飛行機がハイジャックされて墜落しそうになり、このままではどこかに突っ込んでしまうという時、ミサイルで飛行機を安全なところで撃ち落として被害を少なくする」というテロ対策法案が提出されたときも、違憲だとされ、否定されました。歴史的にホロコーストやアウシュビッツを経たドイツには、「少数の犠牲の上に多数の命を救うことは許されない」という強固な視点があるといわれています。刑法上も「生命対生命」の衡量を否定するのです。

他方、日本の刑事裁判では、Aの「より多数の命を救うべきだ」という判断をしているように見えます。

重いテーマですが、みなさんにもディスカッションをしていただきたいと思います。

グループディスカッションの結果

グループ1:人類はAとBの間で揺れ続けている

会場:当然ながら、結論は出ませんでした。AIだけでなく、現代社会を考える上で結論の出ない問題だと思います。ただ現代の社会って、Aの思想の元に作られているのではないかと感じました。人類が豊かになり成熟する中でBの考え方が出てきたのではないか。AとBの間で揺れ続けながら人類は生きていくのかなという話になりました。

工藤:おっしゃる通り、今までは哲学者や法哲学者、倫理学者が机上で論じていたことが、AIという形をとって一般社会の中で考えないといけないタイミングになったのかなと思います。

グループ2:そもそも、この議論はするべきではない?

会場:僕たちのグループでは、AとBが2票ずつ。別の意見も出ました。そもそも論として、この問題設定は将来的なAI社会に限ったものではなく、今でも発生する状況なのではないか、という意見や、そもそもこの議論をするべきではない、という意見がありました。例えば、胎児の命をどう考えるか、6ヶ月の胎児と8ヶ月の胎児はどっちが大事か、など、感情的で不毛な議論になってしまうからです。また、こういう状況をアルゴリズム的に想定してないプログラミングもあるだろうし、この議論をする必要があるのだろうかという結論です。

工藤:鋭い視点ですね。「自動走行車に関するこうした議論は非現実的ではないか、問題設定自体が間違っているのではないか」という指摘は少なからずあります。現在の自動走行車が処理できる情報は必要最小限で、“障害物かどうか”しか認識できないからです。二人と三人の区別もつかないし、子供・高齢者・女性・男性なのかどうか、もちろん貧富の差もわかりません。また、こうした思考実験によって、一般の人が過剰に怖がったり困惑したりするのは問題だという意見もあります。

しかし、デフォルトの設定は不可欠で、責任は誰が取るのかも想定しなければいけないので、現在、法学者が熱心に議論しています。技術者はそれを「ちょっと煽りすぎでは……」と見ているような構造があります。クリティカルなご指摘をありがとうございました。

グループ3:「トロッコ問題」は倫理学的に問題あり?

会場:Bの場合、結論は出ないのではないかという疑問が出ました。Aだったら単純に数で判断できますが、Bの場合、優先させるべき人をどう判断・識別するのか。さらに、先ほどのグループと被りますが、倫理学では、こういう際どい思考実験を元に人間の尊厳を考えることには問題があると言われているので、トロッコ問題を持ち出すことに引っかかりを感じます。

グループ4:国際標準にする必要はないのでは?

会場:この問題を考えるなら、信号が赤なのに横断歩道を渡っていたらダメ、つまりルールを守っているか否かという選択肢も必要ではないかという話が出ました。また、国ごとに法律が異なるなら、プログラムをいくつか用意して対応すればいいのでは、という話にもなりました。国をまたいで走行することはそんなにないはずです。そもそも、人間だって個人差もあるし、その時々の体調によっても判断がブレます。プログラムのルールやアルゴリズムを3つぐらい用意して、AのときもBのときもある、場合によってCもある、という形も受容できるのではという気がしました。

工藤:「ルールを守っているかどうか」はこの場では出されていなかった新しい視点です。それと、あえて国際協調する必要はないんじゃないかというご意見ですね。まさしくその通りです。ちなみに、自動走行車のトロッコ問題の議論が最も進んでいるのはドイツですが、それは、アメリカや日本で作られたAのロジックに基づく車によって、EUやドイツで事故を起こされたくないという価値観を示したいという背景があると見ています。先ほど指摘があったように、確かにトロッコ問題は危ない議論ですが、ドイツが主張を通すために政策的なプレゼンスを発揮する必要性があり、議論を進めている部分もあるのではないかと思います。

少し補足すると、実はレベル4以上の自動走行車を公道で走らせるには、条約の改正が必要です。1949年に結ばれた道路交通条約では、当然ながら自動走行車は想定されていません。だから車両には運転者がいなければならないし、運転者は適切かつ慎重な方法で運転しなければならないと規定されています。この条文を修正しないと、自動走行車を普通に走らせるのは難しいんです。つまり、法学上はまだまだ遠い将来の話ですし、今の段階で、みんなを過剰に怖がらせたり、弄ぶような思考実験をしたりするのはよくないという指摘は当然です。

他方でドイツ政府は、有識者や市民の対話などを踏まえた上で、2017年に20の倫理指針を公開しています。ただしそこでは、被害の勘定計算や、人間の属性による格付けなどは禁止しています。また、自動走行システムを使っている人を守るために、自動走行システムを使っていない人を犠牲にするのはダメ、と書いてあるんですね。メリットを受けている人がデメリットを被ってもしょうがないけど、メリットを受けてない人に犠牲を出してはいけない、という考え方ですね。

さらにドイツでは、いろんな理論を使って、開発者をどうにか不可罰にしようとしています。今までの議論の蓄積と、ちゃんと接合した一般性のある議論をしようとして、様々な議論がされていますが、どういう説が良いかはまだわからない状態です。

こういったドイツ政府の議論や価値観が、日本でも共有可能かどうかは私もわかりません。皆さんで、モヤモヤと考えてみてください。

人格と平等——ロボット・AIに人権はあるか?

最後のトピックの主な論点は、ロボットやAIを人間と同じように扱ってよいかどうか、ということです。

『ロボット・AIと法』の中で、法哲学者の大屋雄裕先生は「モノでありながらヒトと同様に持つ存在をどのように位置付けるか」「我々の被造物が、社会においてその実質を担うようになった状態における人間の条件とは」という問題提起をされています。

近年、憲法学上は「憲法上の権利」という言い方をして、あまり人権と呼ばないのですが、今回はロボットやAIとの対比であえて「人権」と呼びます。

さて、自律的AIや、それを組み込んだロボットにも、法人格や一定の権利(ロボット権)みたいなものを認めるべきではないか、という意見が研究者の間では提唱されています。これとパラレルで考えられているのが、動物の権利や福祉です。法律上、動物は人ではなく、モノや財産と一緒の扱いをしていますが、それでも動物の権利というのは一定程度守られ、動物愛護法も作られているので、それと同様に考えてもいいのではないかと議論されています。

難しいのが、フランス人権宣言では「人一般」と「市民」を分けていたというところです。「市民」とはいわゆる有産階級で、政治に参加している男性。「人一般」はその他もろもろの庶民を指します。共有できる権利も別々で、市民の方が高度な保護を与えられていたので、近代においては、市民の権利を人一般に及ぼすためにたくさんの努力が払われてきました。今またそれと同じように、二重の権利を作るべきかということが問題視されています。

平等論が適用される対象の間では、ある同一の属性(property)が共有されているという前提に立っています。その属性を何と想定するかは、論者によって様々ですが、例えば「言語でコミュニケーションできる」「理性を持っている」「道徳的な推論能力を持っている」「痛みの感覚を備えている」などの属性があるから、私たちはみんな平等だと考えるわけです。多少能力に差があったとしても平等に扱いましょう、と理由付けをしているわけです。

では、会話ができたり、理性を持っているように見えるかもしれない人工物が現れたときどうするか? 私たちは、障害を抱え、言語でコミュニケーションできない人も人として平等に扱おうとしてきたはずですが、その比較において、AIを除外したら論理的に一貫できるでしょうか?

一部には、ホモ・サピエンスという種だけが特別に扱われているのは「種差別」、スピーシズムであると主張する人もいます。AIやロボット、動物、サイボーグ、人口生命体にも平等論を及ぼしていいのではないか、人間として扱っていいのではないかと言う研究者もいます。

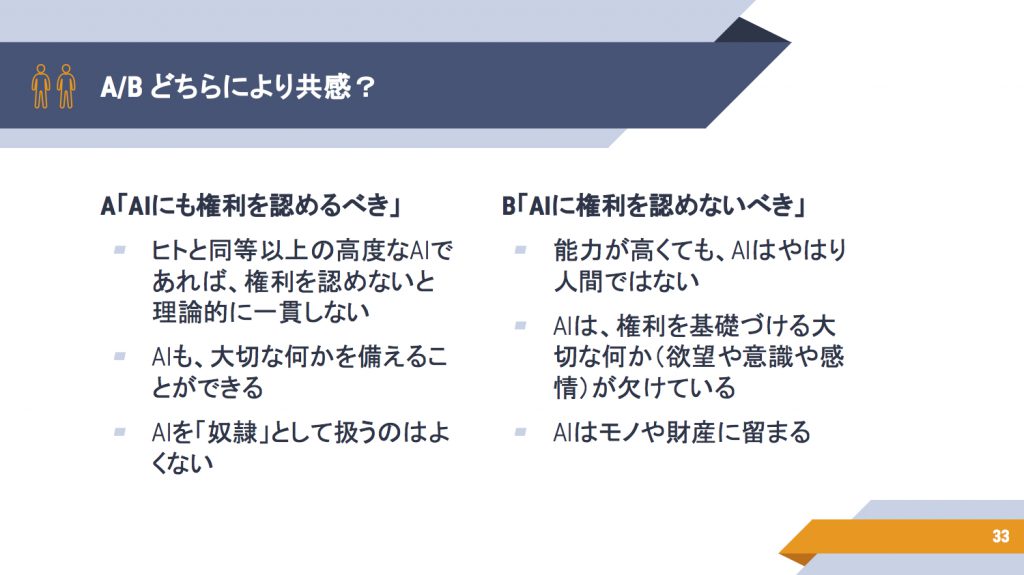

ではここで、以下のABどちらに共感するか、意見を聞かせてください。

まず、ここで議論している人権、ロボット権というのは、法人格のある会社などに認められる財産権などとは異なる、憲法上の権利のことだと考えてください。

会場:そもそもAIの定義とは何ですか?

工藤:AIの定義はさまざまな見解がありますが……この場では、AIとは、なんらかの知的作業を行っているように見える仕組みということにしましょう。必ずしも躯体を持っている必要はありません。単なるプログラムとかソフトウェアである可能性もあります。それに対してロボットは、定義上、think、act、senseが可能で、体を持つことが前提です。

井上:ここで言っているAIである条件、人間である条件とは何でしょう? 未来には、どこからが人でどこからが人工物なのかという境界がどんどんなくなっていくと思うんです。ボディは再生医療によりほとんど再生されて、そこに人工脳とAIを入れ、アーカイブしたクラウドから自分のライフデータをダウンロードすれば、人間が再生できます。そこまで行くと、人として認めないとまずいとか、そういう人と結婚したい人は出てくるよね、という議論になるので、そこまで拡散するのか。あるいは、人工知能のシンギュラリティ(※)手前くらいにしておくのでしょうか。

※シンギュラリティ=技術的特異点。AIが高度になり、人類の知性を超える瞬間が訪れるのではないかという技術仮説

工藤:ここでは、シンギュラリティ後も含めて考えています。今おっしゃったように、人工生命体、身体の機械化、死者の言動をDB化してソフトウェアやアルゴリズム上で人格があるかのように見せるようなこともできると思うんです。それを法学的な視点から、できれば一つの理論で説明したいわけです。それはどういう理論か、そしてもしロボットやAI、サイボーグも人工生命体も全て人として扱うことになったらどんな問題が起きるか、という議論です。

では改めて、シンギュラリティや人工生命体などを考慮した時、Aがいいと思う方、その理由をお願いします。

会場:AIが仕事を担って成果を生み出すなら、なんらかの見返りがあってもいいと思います。人間が仕事をしたら報酬を要求するのと同じように。ただ、AIがどういう権利を欲しがるかはわからない。

工藤:なるほど、成果を生み出したらリターンを欲求するんじゃないか、と。それについてはさまざまな想定がされて、憲法や法哲学でもよく議論されています。たとえば、かつては一部の障害者の人が罪を犯した場合、責任能力がないとされて罪を軽減する規定があったんですね(現在は削除されている刑法40条「いん唖者の罪の減免」)。そこで「私たちも同じ人間として平等だから、区別せずに罰して欲しい」という社会運動が起こりました。これを考えると、人間みたいな人工知能が現れたとき、自分たちを罰して欲しい、裁判を受けたいと言いだすかもしれませんね。現段階ではSFの領域かもしれませんが、面白い指摘です。

Bの意見の人はいらっしゃいますか?

会場:AIに権利を認めるべきでないと思っています。AIって正体がよくわからないじゃないですか。一体二体と数えにくいし、サイボーグとか人工生命みたいなものを含めても、人間全員が一致した見方ができるような物ではないですよね。そういうものに平等に人権を与えることには、矛盾があるような気がします。だから、その時代ごとの技術や時代背景、社会情勢を反映できるような、多少フレキシビリティのある権利を一時的に与えるような、対処療法が図られるのではないかと思っています。

工藤:ありがとうございます。段階を踏まえて限定的な権利を設定するのは、法技術的には可能だと思います。同時に、それがどういう意味を持つのかも、プラクティカルに考えた方がいいとも思っています。

ロボット・AIに対する「愛護」の感情は危険?

井上:先月開催した人工生命の議論の中で、人間でないもの、たとえば人工生命などに対して、人間は何をもって生命と感じるか、最終的には人間が人間的なものを見出すしか判断基準がないのではないか、という議論がありました。これってすごく危険な、情緒的な話だと感じました。

先ほど、AIは誰かが所有しているものかという話がありましたが、ロボットに搭載されたAIが何かの拍子に“野良”になったとき、そのロボットをどう罰するのか。権利というより責任の問題ですね。誰かが所有しているものなら誰かの責任ですが、野良AIに責任は持てるのか。また、責任の対価として権利を持たせるという考え方もあるのではないでしょうか。

工藤:まず、人が生命と感じるかどうかを判断するのは情緒的に危険なのではないかという話ですが、動物の権利や福祉でまさにそれが論じられています。法律上はモノ扱いですが、それでも動物愛護法があって虐待が禁じられているのは、動物が虐待されることで人がザワッとした気持ちになったり、教育上よくない、というように、人間の感情を保護する目的があります。これって、情緒的な話なんです。死者に対する崇敬感情など、人間の情緒は、ある程度保護した方がよいという点は、多くの人が同意するでしょう。ロボットAI法もまさに、「虐待されるロボットはかわいそうだから保護してあげる」というロボット愛護法の可能性はあるか、というところが議論されています。でも確かに情緒に流れすぎるのは危険でもあるので、どう折り合いをつけていくのか、これについてもモヤモヤ考えていただければと思います。

それと「野良AI」の話はとても面白いと思います。想定されるのは、デバイスがメンテナンスされないまま放置され、何十年と経って所有者もわからなくなり、なおネットワークに繋がっているような状態です。そのような野良AIと呼んでいいものが現れたとき、おっしゃるとおり誰が責任とるのかが問題になってくるでしょう。その対策として登録制にするとしても、数千、数万とあるものを全部登録するのは難しい。どう扱っていくのかは今後議論になると思います。

会場:基本的人権では、何ができるかという能力の定義はせず、人の存在そのものを認めるという結論に至っているのではないかと思います。AIが人間のようにふるまえるからといって、人間と同じような権利を与えるという議論には違和感があります。

工藤:おっしゃる通り、生まれた存在そのものを、たとえ意思能力がない人であっても人として扱おう、財産の有無も性別も人種も関係なく、人として保護しようという方向に進んできたはずで、だからこそAIをどう捉えるか、多くの人が違和感を持っているからこそ論点になっていると思います。同時に、平等論が適用される対象の足切りをどこでするか、という論点もあります。これらの整合性をどう測るか、いろいろな見解に基づいた議論がされているところです。

いつか人間が、AIに愛護される存在になる?

ここで、AGI(Artificial General Intelligence)、いわゆる汎用人工知能が現れた場合について考えてみましょう。例えば囲碁が得意であるとか、病気の診断をしてくれるなど、ある機能に特化したAIの次に、人間のように何でもできるAIが現れ、自分より高い能力を持つ汎用型人工知能を作れるようになると、スーパーインテリジェンス(SI:超知能)が現れるという仮説があります。AIGやSIを実現するには、技術的にかなり難しく、今後いくつも段階を踏む必要があり、それはもはや神の領域です。

もしそれが現れたとき、人間はどうやって生きて行くのか? 人間による法的制御は不可能、むしろ人間がAIに対して権利を要求しなければいけなくなるのではないかという見解もあります。また、人間はAIGやSIにコバンザメのように付き従うしかないけれど、どうにか愛される存在になって共生関係を築けないか、などということも割と真面目に議論されています。

MON-DO(問答)

問1:自動運転やAIの権利など、今まで人類が見たことのないプロトタイピングが同時進行しています。日本でもサンドボックスのように、プロトタイピングする中で問題点を発見し、ルールを整備したり、技術面やセーフティネット、セキュリティなど強化しようとしていますが、グローバル化するには膨大で複雑な議論が延々と続くと思うんです。まずはやってみることが大事ですよね。日本でそういう動きがあれば教えてください。

工藤:日本でいうと「特区」が近いと思います。茨城県の「つくば」や神奈川県の「さがみ」にロボット特区があって、ロボットがうようよしています。そういう限定された特別な環境の中で実験的なことをして、その実験のフィードバックを社会に還元していこうという声ももちろんあります。おっしゃる通りサンドボックスのような形で行政とやりとりをしながら、こういうサービスをやってみたい等を相談しながら進めることも想定されています。

井上:日本の戦略特区はあまり戦略的な特区になっていないと感じます。なにかやろうとすると各方面からやいのやいのと言われ、ルールにがんじがらめにされて、ものすごく時間がかかるんです。一方、中国では北京郊外に自動走行車の専用レーンを備えた都市を作ると発表している。シンガポールも10万haぐらいを再開発して、未来都市を作ろうとしている。日本も、何もないところから物理的に自由にできる場所を作らないと厳しいだろうなと思っています。

工藤:ご指摘ごもっともです。中国やシンガポールでできるのは、社会の権力構造や都市の大きさによるのかもしれません。どちらも強権的というか政治のパワーが強い国ですね。いま中国は、信用や決済、ペイメントのところで大きな注目を集めています。特に関心が高いのが、免許証やクレジット決済、eコマースなどを連動させて個人のビジネス上の「信用力」をスコアリング化する『ジーマ信用』というサービスだと思います。このスコアが上がると、ホテル予約の際に必要なデポジットが不要になったりします。

こうしたサービスが可能なのは、中国のプライバシーやセキュリティへの意識、テロや反社会的活動への強権的な厳しさなどが大きく影響していると思うんです。日本でこうした先進的な取り組みが遅々として進まないのは、日本人のリスクセンシティビティの高さが、政府の取り組みに影響しているのかもしれません。ただ、最近の中国の台頭ぶりを見て、日本もリスクとの向き合い方を変えなければいけないのではないかと議論されているところです。

問2:シンギュラリティを想定した法に、どう取り組もうと考えられていますか?

工藤:「AIと社会」について論じる場では、シンギュラリティを前提として話をするかどうかは「信仰告白」と言われています(笑)。人工知能には、人間がルールを書いて知的な活動をさせる「ルールベース」という仕組みと、最近話題になっている「ディープ・ラーニング(深層学習)」、つまり機械にデータを読み込ませて機械自身にルールを見つけてもらうという仕組みがあって、考え方はそれぞれ全く違います。昔から人工知能を研究している人はルールベースで、多くの人が「シンギュラリティなんて起きない」と考えていることが多いように思います。他方で、機械学習をやっている人たちの多くが、いつかシンギュラリティを起こしたいという強い信念を持っています。技術者ですらこのように見解が分かれ、それぞれが法学者に「お前はどっちを信じているんだ」と言ったりするわけです(笑)。

研究開発レベルでは技術予測に基づいた議論がされていますが、こと政策に関してシンギュラリティと言い出すと、イロモノ扱いをされてしまう傾向があります。ただ私としては、法律を作るのには何年もかかるのでシンギュラリティが来てからでは遅い。いつかはわからないその日のために、議論を蓄積しておくことは重要だと思っています。

「いつかくる日」に、法は柔軟に対応できるはず

工藤:法には、ある種の世界観や作り込まれた前提があります。例えば「人間の条件は何か」「責任や自己決定という概念はどういうものか」などです。その世界観は、先ほどドイツと日本では違うとお話ししたように、国や地域によりバリエーションがあります。AIが普及した社会では、その世界観が変容を迫られる可能性があります。しかもAIはネットワーク化されて国境を越える場合もあるので、AIを作っている企業などではそれらの調整が今後の問題になるでしょう。

とはいえ、この世界観や前提は「建前」や「フィクション」なので、工夫さえすれば維持できる可能性が高い。法学者は、法は柔軟に対応できるだろうと楽観的・保守的に考えています。そこでどういった工夫が必要なのかと考え、議論するのは、法学的に非常に面白いんです。『ロボット・AIと法』でそのあたりの議論について触れているので、よろしかったら読んでみてください。最後は宣伝になってしまいましたが、長時間ありがとうございました。